Das moralische Dilemma von Data

Zu den technischen Innovationen der letzten Jahre gehört, dass ein breiter Teil der Menschen mit KI-Systemen in Berührung kommt, deren Verhalten nicht mehr mechanisch vorhersagbar ist. Waren selbstlernende Systeme über Jahrzehnte ein Spielfeld der Forscher:innen in den Laboren, drängen sie nun mit Fahrassistenzsystemen für Elektroautos und generativer KI wie ChatGPT in den Alltag der Menschen. Waren dabei bisher Fehler der konstruierten Systeme immer eindeutig den erbauenden Ingenieur:innen und deren Geldgebern anzulasten, muss sich die Gesellschaft nun damit auseinandersetzen, dass die automatisch getroffenen Entscheidungen mal so oder so, manchmal sogar schädlich sein können, und niemand ist verantwortlich. Warum das so ist, erklärt sich aus alten ethischen Fragestellungen – wie dem rechtlichen Umgang mit Dilemma-Situationen.

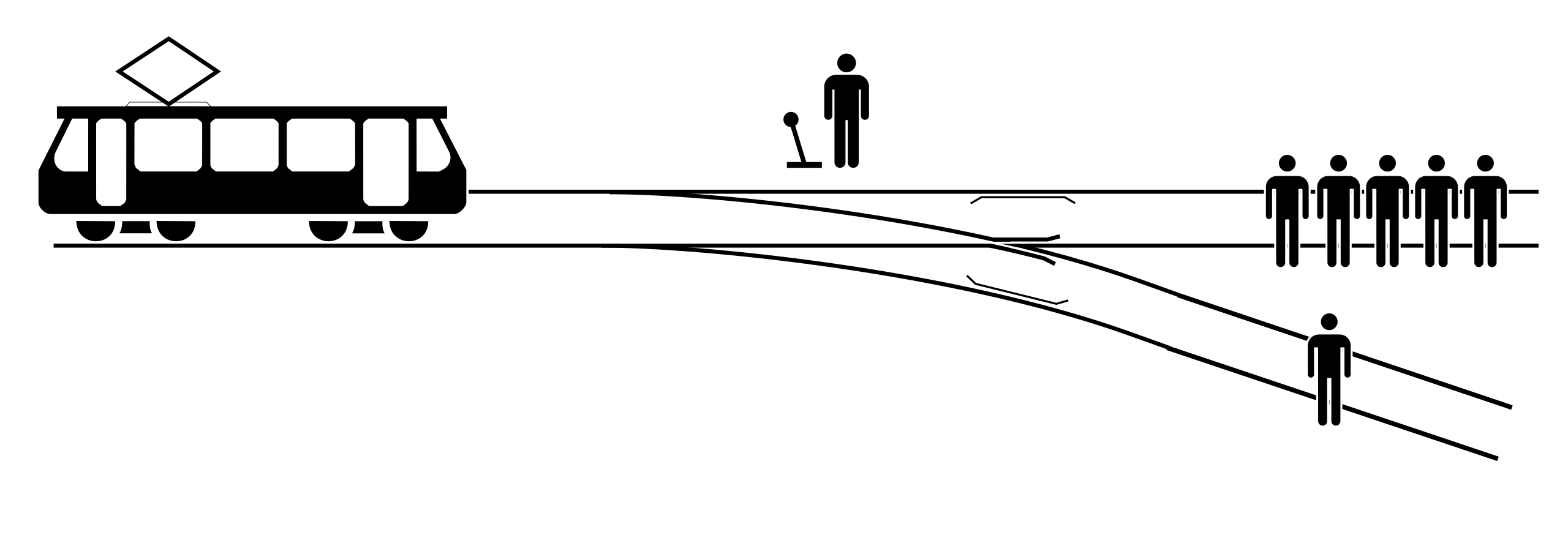

Bevor man sich der künstlerischen Verarbeitung bei Data widmet, eine kurze Erinnerung zu Dilemma-Situationen: Gemeint sind dabei Situationen, in denen man zwar die freie Wahl einer Entscheidung hat, beide Entscheidungen aber negative Konsequenzen haben. Den Umgang der Menschen damit hat man in der Psychologie mit dem Trolley-Problem und dessen Varianten untersucht. Hierbei fährt ein Zug auf eine Menschenmenge zu, aber es besteht die Möglichkeit eine Weiche zu stellen, um diese Konsequenz abzuwenden. Jedoch steht auf dem anderen Gleis auch ein Mensch, der gefährdet wird. Was tun?

Nun, es ist eine Aufgabe, die keine eindeutige Lösung hat. Man fragt hier nach Leitlinien, die Menschen bewusst oder unbewusst einsetzen, die zu Abwägungen und einem verantwortungsvollen Handeln führen. Mit dem Aufkommen von komplexen Systemen müssten nun eigentlich die Leitlinien den automatischen Systemen beigebracht werden. Aber welche?

Was wir aus den bisherigen Untersuchungen schon wissen ist, dass es hier keine universale Moral gibt. Schon bei dem Trolley-Problem zeigte sich, dass Menschen in Europa und der westlichen Welt versuchen, die Mehrheit abzuzählen und zu retten, und im gezeigten Beispiel mehrheitlich dazu neigen, die Weiche zu stellen. In anderen Kulturen versucht man jedoch Handeln zu vermeiden, das Menschen schaden oder gar töten könnte, mit den daraus resultierenden Anklagen. Dort wird man mehrheitlich die Weiche nicht umstellen, und kann damit die Verantwortung für die Konsequenzen vermeiden. Wenn schon die Individuen sich unterschiedlich entscheiden, kann eine globale Debatte ebenso kein eindeutiges Ergebnis liefern.

Durch die technische Evolution stellen sich uns diese Fragen nun auch für die Entscheidungen der komplexeren Systeme. Denn auf der einen Seite sollen technische Systeme das Leben der Menschen erleichtern und eine Gefährdung reduzieren, aber anderseits werden technische Systeme nur akzeptiert, wenn sie in komplexen Situationen besser sind als Menschen - und damit auch in Dilemma-Situationen einem höheren moralischen Anspruch gerecht werden. Zumindest sollten sie zu einem höheren Prozentsatz ein bevorzugtes Ergebnis in solchen Situationen erreichen.

Statt sich dem Thema abstrakt zu nähern, kann man sich auch eine Folge der Serie Raumschiff Enterprise anschauen (Star Trek Next Generation), die sehr viele Zuschauer emotional aufgewühlt hatte. In der Episode „The Most Toys / Der Sammler“, Erstausstrahlung 1990, haben dabei die Drehbuchautoren die alte Fragestellung ausgesprochen und vielschichtig verarbeitet. Als Ausgangslage wird dabei ein Bösewicht „Fajo“ herausgearbeitet, der gar keine klassischen bösen Ziele hat, sondern dem in seiner Sammellust die ethischen Konzepte anderer einfach egal sind.

Dazu gehört, dass er auch Menschen wie Varria oder den Androiden Data

gefangen hält und als Teil seiner Ausstellung präsentiert. In einer

Diskussion zwischen Fajo und Data wird dabei das spätere moralische

Dilemma vorbereitet – auf die Frage nach Handeln und Konsequenzen stellt

Fajo die Frage „Hast du jemals getötet? / Have you killed yet?“. Data

antwortet darauf: „Nein, aber ich wurde programmiert tödliche Gewalt zum

Zwecke der Verteidigung einzusetzen. / No, but I am programmed to use

deadly force for the cause of defense.“ Damit ist sich Fajo sicher, dass

Data ihn nicht töten kann, wenn er ihn nicht direkt bedroht.

In einer folgenden Szene versuchen nun Varria und Data zu fliehen. Jedoch ertappt Fajo die beiden, und Fajo entschließt sich, Varria vor den Augen von Data zu töten. Anschließend wirft er die Waffe weg – er steht also unbewaffnet vor dem Androiden, zu dessen höchsten Leitlinien gehört, dass er nur zur Verteidigung töten darf. Aber Fajo will die Situation noch viel weiter ausnutzen – er möchte, dass sich Data seinem Willen fügt und kündigt an, wenn er nicht in seiner Ausstellung mitmacht, werden weitere Menschen sterben. Hier …. muss Data nun abwägen. Er sagt schließlich den Kernsatz „Ich kann das nicht weiter zulassen / I can not permit this to continue“, und hebt die Waffe zum Schuss.

Doch die Drehbuchautoren haben hier noch einen draufgesetzt. Kein Schuss löst sich, stattdessen wird Data in just diesem Moment auf das Raumschiff zurückgebeamt. Der Techniker behauptet, dass die Waffe aktiv sei, und schaltet sie ab. Der Führungsoffizier Ryker fragt nun Data danach, worauf dieser jedoch antwortet „Vielleicht ist was beim Transport schiefgelaufen. / Perhaps something occurred during transport“. Der Zuschauer wird nun mit der Frage zurückgelassen – hat er geschossen und gelogen? Und dann natürlich – warum? Und warum wird es von Ryker akzeptiert?

Dahinter verbirgt sich der Wunsch der Menschen nach Sicherheit. Das Zusammenleben mit Maschinen erfordert, dass diese uns nicht gefährlich werden können. Immer und immer wieder zeigt sich dabei in der Serie, dass der Android Data dabei höhere moralischen Anforderungen erfüllt als die fehlerbehafteten Menschen um ihn herum. Eine Maschine, die aus einer bloßen Kalkulation heraus tötet, würde immer beunruhigen, obwohl die Entscheidung in der Folge für die Zuschauer nachvollziehbar ist. Das moralische Ansehen von Data in der Gesellschaft ist letztlich höher zu gewichten als der Waffengebrauch an sich.

Die Menschen nicht zu beunruhigen und ihnen Roboter als grundlegend ungefährlich erscheinen zu lassen, ist übrigens ein sehr altes Konzept. Dies wurde von Asimov schon 1942 in „Robotergesetze“ eines Romans formuliert, die von den folgenden Generationen von Ingenieur:innen verinnerlicht wurden. In einem späteren Roman fügt Asimov dann noch ein „Nulltes Gesetz“ hinzu, dass über allen anderen steht: „Ein Roboter darf die Menschheit nicht verletzen oder durch Passivität zulassen, dass die Menschheit zu Schaden kommt.“

Tatsächlich passiert jedoch genau das bereits. Selbstfahrende Autos haben im Testbetrieb schon Menschen schlichtweg überfahren. In der Folge wurde die Frage nach der Haftung der Ethikkommission vorlegt. Die sich dann auch wörtlich 2017 äußerte mit den Worten: „Wir werden in vielen klassischen Dilemma-Situationen enden“, und keine letzte Leitlinie entwarf. Stattdessen arbeiteten sie philosophisch heraus, dass bei zwei falschen Entscheidungen kein strafrechtlicher Vorwurf ergehen darf – es obliegt dem Staat also gerade nicht, die falsche Entscheidung der Maschine zu bekämpfen, egal welche nun gewählt wurde.

Das darf uns aufwühlen, denn es erscheint, dass Hersteller aus der Haftung für das Produkt genommen werden. Das Risiko wird auf die Halter übertragen, die das aber gar nicht beeinflussen können. Das ist natürlich nicht gewünscht, aber die Hersteller können ja zurückfragen, wie denn bitte die Richtlinien aussehen sollen, die sie dann umsetzen sollten. Dies würde entsprechend der Gesellschaft die Pflicht auferlegen, nun möglichst bald alle Fragestellungen zu lösen, die bei Abwägungen über Menschen auftreten können - insbesondere warum manche Menschen weniger wert erscheinen, letztlich diskriminiert werden, und warum real manche Menschengruppen marginalisiert werden. Der Philosoph Lutz Bachmann gab ein Beispiel mit „Wen fahre ich eher um: die junge Familie oder den Rentner rechts von mir?“.

Bibliographie:

Zeit (2017). "Wir werden in vielen klassischen Dilemma-Situationen enden". https://www.zeit.de/gesellscha... (abgerufen 25.06.2023)

YouTube (2023a). Star Trek STNG Moments 70 The Most Toys. https://www.youtube.com/watch?v=_skkBMvlWBw copyright Paramount Picture (abgerufen 25.06.2023)

YouTube (2023b). Have you killed yet. https://www.youtube.com/watch?v=xgKx1f3aemA (abgerufen 25.06.2023)

Photos: Teaser – “Data“ copyright Paramount Pictures (YouTube, 2023b)

Header : Freepik Hyperraum

Kommentar schreiben

Ihre E-Mail-Adresse wird nicht veröffentlicht. Kommentare werden erst nach Moderation freigeschaltet.

Kommentare ()